بررسی مقایسه ای پیاده سازی قابل ترکیب بندی مجدد شبکه های یادگیری عمیقدرکاربردهای خودروهای خودران

- ۰ نظر

- ۲۲ اسفند ۰۲ ، ۱۷:۰۸

در نورسنجی، شار نوری (نام علمی: Luminous flux)، توان نوری یا میزان نور،[۵] معیاری است برای سنجش توان دریافت شده از نور. شار نوری را نباید با شار تابشی که معیاری برای سنجش توان کل نور گسیلشدهاست اشتباه گرفت زیرا شار نوری به گونهای تعریف شده تا بازتابدهندهٔ حساسیت متغیر چشم انسان به طول موجهای مختلف نور باشد.

در دستگاه بینالمللی یکاها، یکای شار نوری، لومن (lm) است. هر لومن به صورت شار نوری تولیدشده توسط یک منبع نوری با شدت روشنایی یک کاندلا در زاویهٔ فضایی یک استرادیان تعریف میشود. در دیگر دستگاههای اندازهگیری، شار نوری ممکن است با توان همیکا باشد.

واسط مغز-رایانه (brain–computer interface) (مخفف: BCI)، که برخی مواقع به آن واسط مغز-ماشین (BMI) نیز گفته میشود، یک مسیر مستقیم ارتباطی بین فعالیتهای الکتریکی مغزی و یک دستگاه خارجی است که اغلب یک کامپیوتر یا عضو رباتیک میباشد. واسطهای مغز و رایانه اغلب برای چنین اهدافی به کار میروند: تحقیقات، نگاشت مغزی، یاریگری، ازدیاد توانایی انسان، ترمیم ادراک انسانی یا عملکردهای حسی-حرکتی.[۱] دامنه پیادهسازیهای BCIها در چنین مواردی است: EEG، MEG، EOG، MRI، که برحسب این که الکترودها تا چه میزان نزدیک بافت عصبی باشند، برخی تاحدی تهاجمی (مثل ECoG و درون-عروقی) و برخی دیگر تهاجمی (مثل آرایه میکروالکترودی) هستند.[۲]

تحقیقات بر روی BCIها در دهه ۱۹۷۰ میلادی توسط «ژاک وایدال» (Jacques Vaidal) در دانشگاه کالیفرنیا در لس آنجلس (UCLA) تحت کمک هزینه از سوی بنیاد ملی علوم و در پی بسته شدن قراردادی با دارپا شروع شد.[۳][۴] مقاله ۱۹۷۳ میلادی وایدال، اولین ظهور عبارت «واسط مغز-کامپیوتر» در متون علمی است.

بر اساس قابلیت انعطافپذیری غشای خارجی مغز، پیامهایی که از اندامهای ساختگی کاشته شده ارسال میگردند، پس از سازگاری، میتوانند مانند ارتباطات طبیعی حسی-حرکتی توسط مغز کنترل شوند.[۵] پس از سالها آزمایش بر روی جانوران، اولین دستگاههای نوروپروستتیک کاشته شده در انسانها طی اواسط دهه ۱۹۹۰ میلادی ظهور پیدا کردند.

اخیراً مطالعاتی در زمینهٔ تعامل انسان و رایانه صورت گرفته که در آن از یادگیری ماشین برای تحلیل دادههای آماری زمانی استخراج شده از لوب پیشانی (نوار مغزی EEG) استفاده کردهاند و در نتیجه آن موفقیت بالایی در ردهبندی حالات ذهنی (استراحت، خنثی، تمرکز)،[۶] حالات هیجانی ذهنی (منفی، خنثی، مثبت)[۷] و دیسریتمیای تالاموکورتیکال بدست آمدهاست.[۸]

نوروروباتیک (Neurorobotics)، علم و فناوری مربوط به سیستمهای عصبی خودکار تجسم یافتهاست که یک مطالعه ترکیبی از علوم اعصاب، روباتیک و هوش مصنوعی میباشد. سیستمهای عصبی شامل الگوریتمهای تأثیر گرفته از مغز (به عنوان مثال شبکههای اتصال دهنده)، مدلهای محاسباتی مربوط به شبکههای عصبی بیولوژیکی (به عنوان مثال شبکههای عصبی اسپایکی و شبیهسازی میکرومدارهای عصبی در مقیاس بزرگ) و سیستمهای بیولوژیکی حقیقی (مانند شبکههای عصبی داخل و خارج بدن) هستند. چنین سیستمهای عصبی را میتوان در ماشینهایی با عملکرد مکانیکی یا هر شکل دیگری از تحریک فیزیکی مجسم کرد. این ماشینها شامل روباتها، سیستمهای پروتزی یا سیستمهای پوشیدنی (wearable systems)، میکرو ماشینها در مقیاس کوچکتر و تجهیزات و دستگاهها در مقیاس بزرگتر میباشد. نوروروباتیک شاخه ای از علوم اعصاب (نوروساینس) ترکیب شده با روباتیک است، که به مطالعه و کاربرد علم و فناوری مربوط به سیستمهای عصبی خودکار تجسم یافته، مانند الگوریتمهای الهام گرفته از مغز میپردازد. ایده اصلی نوروروباتیک آن است که یک مغز برای روبات در نظر گرفته میشود و جسم فیزیکی آن برای انجام عمل در محیط قرار میگیرد؛ بنابراین، بسیاری از نوروروباتها موظفند بر خلاف یک محیط شبیهسازی شده، در دنیای واقعی عمل کنند.[۱]

نوروروباتیک بیانگر یک رویکرد دو طرفه از مطالعه هوش است. علوم اعصاب تلاش میکند با بررسی سیستمهای هوشمند بیولوژیکی، چگونگی عملکرد و اجزای هوش را تعیین کند، در حالی که مطالعه هوش مصنوعی تلاش میکند تا با استفاده از روشهای غیر بیولوژیکی یا ابزارهای مصنوعی، هوش را دوباره به وجود بیاورد. نوروروباتیک هردو زمینه مطالعاتی فوق را در بر میگیرد، که در آن تئوریهای بر گرفته شده از سیستمهای بیولوژیکی در یک محیطی که بر اساس مدل ارائه شده ایجاد شدهاست، آزمایش میشوند. موفقیتها و شکستهای آزمایش یک نوروروبات و مدلی که از آن ساخته شدهاست میتواند شواهدی را برای رد یا پشتیبانی از آن تئوری فراهم کند و بینشی برای مطالعه آینده باشد.

نوروروبات را میتوان بر اساس هدف ربات به دستههای مختلف تقسیم کرد. هر دسته برای پیادهسازی یک مکانیسم خاص به منظور مطالعه آن مکانیسم طراحی شدهاست. انواع متداول نوروروباتها مواردی هستند که برای بررسی کنترل حرکتی، حافظه، انتخاب عملکرد و ادراک استفاده میشوند.

نوروروباتها اغلب برای مطالعه فیدبک حرکتی و سیستمهای کنترلی استفاده میشوند و مزیتهای فراوانی دارند. حرکت توسط تعدادی از نظریههای برگرفته شده از عملکرد بخشهای عصبی مربوط به حرکت، مدلسازی میشود. کنترل حرکت از مدلها یا مولدهای الگوی مرکزی شبیهسازی میشود تا روبات چهار پا بسازد. مولدهای الگوی مرکزی مجموعه ای از نورونهای عصبی هستند که باعث ایجاد رفتارهای تکراری میشوند.[۲] گروههای دیگر ایده ترکیب سیستمهای کنترلی ابتدایی را با یک مجموعه سلسله مراتبی از سیستمهای خودکار ساده گسترش دادهاند. این سیستمها میتوانند حرکتهای پیچیده را از ترکیب این زیر مجموعههای ابتدایی بهوجود آورند.[۳] این تئوری مربوط به عملکرد حرکتی مبتنی بر سازماندهی ستونهای قشری مغز میباشد. این ساختار که به تدریج از ورودی حسی ساده شروع میشود و به سیگنالهای پیچیده در فیبر عصبی آوران ختم میشود، یا بالعکس از برنامههای حرکتی پیچیده گرفته تا کنترلهای ساده برای هر فیبر عضلانی در اثر عبور سیگنالهای وابران، یک ساختار سلسله مراتبی مشابهی را تشکیل میدهند.

روش دیگر برای کنترل حرکت استفاده از تصحیح خطای آموخته شده و کنترلهای پیشبینی کننده برای ایجاد نوعی حافظه عضله ای شبیهسازی شدهاست. در این مدل، حرکات تصادفی و دارای خطا با استفاده از فیدبک خطا اصلاح میشوند تا حرکات منظم و دقیقی با گذشت زمان ایجاد شود. کنترلکننده با پیشبینی خطا یادمیگیرد که، سیگنال کنترلی صحیحی را ایجاد کند. با استفاده از این ایدهها، روبات طراحی شده میتواند یاد بگیرد که حرکات تطبیقی انجام دهد[۴] یا در یک مسیر به موانع برخورد نکند.

روباتهایی هستند که برای آزمایش تئوریهای مربوط به سیستمهای حافظه حیوانات طراحی شدهاند. در حال حاضر بسیاری از مطالعات، سیستم حافظه ای موشها را به ویژه هیپوکامپوس موش که با place cells در ارتباط است، بررسی میکند. این سلولها برای مکان خاصی که یادگیری اتفاق میافتد، تحریک میشوند.[۵][۶] سیستمهایی که هیپوکامپوس موش را مدل میکنند، بهطور کلی قادر به ایجاد نقشههای ذهنی از محیط اطراف هستند که این امر به کمک شناخت علائم برجسته ان محیط و نحوه برخورد با آن بر اساس یادگیری انجام میشود و به آنها امکان پیشبینی علائم و موانع نزدیک را میدهد.

مطالعه دیگری یک ربات بر اساس الگوی یادگیری جغد برای جهتیابی و مکانیابی مبتنی بر محرکهای شنیداری و بصری ایجاد کردهاست. این فرضیه شامل پلاستیسیته سیناپسی و مدولاسیون نورونی است.[۷] مدولاسیون نورونی اغلب یک اثر شیمیایی است که در آن انتقال دهندههای عصبی مانند دوپامین یا سروتونین حساسیت نورون را تحت تأثیر قرار میدهند.[۸] روبات مورد استفاده در مطالعه مذکور به اندازه کافی با رفتار جغدها مطابقت داشتهاست.[۹] علاوه بر این تعامل نزدیک بین خروجی سیستم حرکتی و فیدبک شنوایی ثابت کردهاست که تئوریهای حس کردن فعال در فرایند یادگیری نقش بسیار حیاتی دارند و همچنین بسیاری از مدلهای یادگیری شامل این تئوری هستند.

نوروروباتهایی برای یادگیری الگوها یا مارپیچهای ساده در رابطه با این مطالعات ارائه شدهاست. برخی از مشکلات ارائه شده برای نوروروبات شامل تشخیص نمادها، رنگها یا سایر الگوها و اجرای ساده اعمال مبتنی بر الگوها است. در روباتی که بر اساس رفتار جغد شبیهسازی شده بود، روبات برای هدایت خود در محیط باید موقعیت و جهت حرکت را تعیین میکرد.

مطالعات مربوط به انتخاب عمل با نسبت دادن وزن منفی یا مثبت به یک عمل و نتیجه آن سروکار دارد. نوروروباتها میتوانند در مطالعه تعاملات اخلاقی استفاده شوند، مانند آزمایش تفکر قدیمی که تعداد افراد موجود در یک قایق نجات از ظرفیت آن بیشتر بوده و یک نفر برای نجات بقیه باید قایق را ترک کند. با این حال، تعداد بیشتری از نورو روباتها در بررسی انتخاب عمل، کارهایی را انجام میدادند که با عقیده بسیار ساده مانند حفظ و نجات خود یا حفظ جمعیت روباتها مخالف بودند. این نوروروباتها پس از مدولاسیون نورونی سیناپسها برای تقویت مدارهایی با نتایج مثبت مدل میشوند.[۱۰][۱۱] در سیستمهای بیولوژیکی ، انتقال دهندههای عصبی مانند دوپامین یا استیل کولین سیگنالهای عصبی مفید را تقویت میکنند. یک مطالعه از چنین تعامل شامل روبات داروین هفت بود که از حس بینایی، شنیداری و حس چشایی شبیهسازی شده به عنوان ورودی برای بلوکهای فلزی رسانا استفاده میکرد. انتخاب تصادفی بلوکهای خوب از نظر ارزش گذاری، دارای الگوی راه راه بر روی خود بودند هنگامی که بلوکهای بد یک شکل دایره ای روی خود داشتند. حس چشایی با میزان رسانایی بلوکها شبیهسازی میشود. روبات با توجه به سطح رسانایی بلوکها، فیدبکهای مثبت و منفی ای را از مزه آن ارائه میدهد. محققان در این آزمایش مشاهده کردند که ربات چگونه رفتارها و عملکردهای انتخابی خود را بر اساس ورودیهای مختلف، آموختهاست.[۱۲] مطالعات دیگر از گروههایی از روباتهای کوچک استفاده کردهاند که از باتریهای پخش شده در اطراف اتاق تغذیه میکردند و یافتههای خود را به سایر روباتها ابلاغ میکردند.[۱۳]

نوروروباتها همچنین برای مطالعه درک حسی، به ویژه بینایی استفاده شدهاند. اینها در اصل سیستمهایی هستند که از تعبیه مدلهای عصبی مربوط به مسیرهای حسی در ماشینهای خودکار بهوجود میآیند. این روش بر اساس سیگنالهای حسی است که در طول انجام عمل رخ میدهد و همچنین ارزیابی واقعی تری را از میزان مقاوم بودن مدل عصبی امکانپذیر میکند. واضح است که تغییرات ناشی از فعالیت حرکتی در سیگنالهای حسی، نشانههای ادراکی مفیدی را توسط ارگانیسمها فراهم میکند که بهطور گسترده مورد استفاده قرار میگیرند. به عنوان مثال، محققان از اطلاعاتی که از حرکات سر و چشم انسان بدست می آید برای ایجاد نمایش مفهوم داری از صحنه بصری استفاده کردهاند.[۱۴][۱۵]

روباتهای بیولوژیکی در واقع نوروروبات نیستند زیرا در آنها از نظر نورولوژیکی از سیستم هوش مصنوعی برگرفته نشدهاست، بلکه بافتهای عصبی واقعی هستند که به یک ربات وصل میشوند. این رباتها از شبکههای عصبی کشت شده برای مطالعه رشد مغز یا تعاملات عصبی استفاده میکنند. این رباتها بهطور معمول شامل یک مجموعه عصبی هستند که بر روی یک آرایه چند الکترودی (MEA) قرار گرفتهاند و قادر به ضبط فعالیت عصبی و تحریک بافت هستند. در بعضی موارد، MEA به رایانه ای متصل میشود که محیط شبیهسازی شدهای را برای بافت مغز ایجاد میکند و فعالیت مغز را به صورت یک عمل متناظر با ان فعالیت، شبیهسازی میکند.[۱۶] توانایی ضبط فعالیت عصبی به محققان امکان استفاده از این دادهها را برای آموزش نوروروباتها دادهاست.

بخشی که در ان روباتهای بیولوژیکی با ان درگیر هستند بحث اخلاق است. سؤالات زیادی دربارهٔ نحوه انجام آزمایشهایی دربارهٔ این موضوع مطرح میشود. مهمترین سؤال بحث آگاهی است و اینکه آیا مغز موش آن را تجربه میکند یا خیر. این بحث به نظریههای بسیاری درمورد اینکه آگاهی چیست، میرسد.[۱۷][۱۸]

برای اطلاعات بیشتر ببینید: هیبروت، آگاهی

دانشمندان علوم اعصاب از نوروروباتیک استفادهای زیادی میکنند زیرا یک محیط قابل کنترل برای آزمایش نحوه عملکرد مغز فراهم میکند. علاوه بر این، چون روباتها نمونههای سادهتری از سیستمهایی هستند که از آنها پیروی میکنند، امکان آزمایشهای بیشتر و بررسی مستقیم در مسائل موجود فراهم میشود.[۱۹] علاوه بر این، این مزیت را دارند که در همواره قابل دسترس هستند، در حالی که زیر نظر داشتن بخشهای گسترده از مغز در حالی که حیوان زنده است، دشوار است و بررسی تک تک نورونها تقریباً امکانپذیر نیست.

با توجه به پیشرفت در زمینه علوم اعصاب، روشهای درمانی متعددی از جمله، روشهای دارویی و توان بخشی عصبی پدید آمدهاند.[۲۰] پیشرفت در این حوزه به درک پیچیدگی مغز و نحوه عملکرد دقیق آن بستگی دارد. مطالعه مغز به ویژه در انسانها به دلیل خطر ناشی از جراحی دشوار است؛ بنابراین، استفاده از فناوری بررسی مغز کار بسیار مهمی است. نوروروباتها دقیقاً این وظیفه را انجام میدهند و بسیاری از آزمایشهایی را پوشش میدهند که میتواند در مطالعه فرایندهای عصبی منجر به پیشرفت چشمگیری شود.

برنامه محاسبات و سیستمهای عصبی[الف] (سیاناس) در سال ۱۹۸۶ در موسسه فناوری کالیفرنیا تأسیس شد. هدف از تأسیس این برنامه، آموزش دانشجویان دوره دکتری علاقهمند به بررسی رابطه بین ساختار مدارها/شبکههای شبیه نورون و محاسبات انجام شده در چنین سیستمهایی، خواه طبیعی یا مصنوعی، هستند. این برنامه برای تقویت تبادل ایده و همکاری مهندسین، علوم اعصاب و نظریه پردازان طراحی شدهاست.

در اوایل دهه ۱۹۸۰، با ایجاد مبانی ویاِلاِسآی،[۱] کارور مید[ب] به بررسی شباهت بین محاسبات انجام شده در مغز و نوع محاسباتی که میتواند در مدارهای الکترونیکی سیلیکونی آنالوگ انجام شود، علاقهمند شد. در راستای گسترش مطالعات خود، مید به جان هاپفیلد پیوست که در زمینه مبانی نظری محاسبات عصبی،[۲] در حال تحصیل بود. اولین دوره مشترک مید و هاپفیلد در این زمینه با عنوان «فیزیک محاسبات» برگزار شد؛ هاپفیلد در مورد کار خود در شبکههای عصبی و مید در مورد کار خود در زمینه تکرار ساختارهای عصبی در مدارهای الکترونیکی بسیار یکپارچه تدریس میکردند.[۳] با توجه به علاقه دانشجویان و دانشکدهها، آنها تصمیم گرفتند تا در سال بعد بر این مضامین گسترش دهند. ریچارد فاینمن به آنها پیوست و سه دوره جداگانه نتیجه گرفت: هاپفیلد در شبکههای عصبی، مید در مدارهای آنالوگ عصبی،[۴] و دوره فاینمن دربارهٔ فیزیک محاسبات.[۳][۵] در این مرحله، مید و هاپفیلد فهمیدند که حوزه جدیدی پا به عرصه گذاشتهاست که در آن، دانشمندان اعصاب و افرادی که مدلها و مدارهای رایانه ای را انجام میدهند در حال گفتگو هستند.

در پاییز ۱۹۸۶، جان هاپفیلد پیشگام تشکیل یک دوره دکتری بینرشتهای شد تا سوالاتی که در مورد ارتباط بین عصبزیستشناسی و مهندسی برق، علوم رایانه و فیزیک به وجود میآیند، مورد مطالعه قرار گیرند. این دوره سیستمهای محاسباتی و عصبی (سیاناس) نامیده شد و موضوع وحدت بخش آن، ارتباط بین ساختار فیزیکی یک سیستم محاسباتی (سختافزار فیزیکی یا بیولوژیکی)، پویایی عملکرد آن و نیز مشکلات محاسباتی است که میتواند بهطور مؤثر حل کند. ایجاد این برنامه چند رشتهای عمدتاً ناشی از پیشرفت در چندین جبهه است که قبلاً نامرتبط انگاشته میشدند: تجزیه و تحلیل سیستمهای عصبی پیچیده در هر دو سطح تک سلولی و شبکههای سلولی[۶] با استفاده از تکنیکهای مختلف (به ویژه، ضبط گیره پچ[پ]، الکتروفیزیولوژی درون و بین یاختهای یک یا چند سلول ناشی از تکنیکهای تصویربرداری از مغز حیوانات و تصویربرداری عصبی کارکردی مانند تصویربرداری تشدید مغناطیسی کارکردی)، تجزیه و تحلیل نظری ساختارهای عصبی (علوم اعصاب محاسباتی) و مدلسازی شبکههای عصبی مصنوعی برای اهداف مهندسی.[۲] این برنامه با تعداد کمی از دانشکدههای موجود در بخشهای مختلف آغاز شد. کارور مید، جان هاپفیلد، دیوید ون اسن[ت] جفری فاکس[ث]، جیمز باوور[ج]، مارک کونیشی[چ]، جان آلمان[ح]، اد پوزنر و دمیتری سوالتیس[خ] حضور داشتند. اولین استاد خارجی، کریستوف کخ، در آن سال استخدام شد.

از سال ۱۹۹۰، به حدود ۱۱۰ دانشجوی تحصیلات تکمیلی مدرک دکترا و به ۱۴ دانشجو، مدرک کارشناسی ارشد در سیاناس اعطا شدهاست. حدود دو سوم از فارغ التحصیلان سیاناس مشاغل دانشگاهی را دنبال کردند و بقیه فارغ التحصیلان یا خود شرکتهای نوپا ایجاد کردند یا به شرکتهای نوپا پیوستند. در این مدت، میانگین مدت دوره دکترا ۵٫۶ سال بودهاست.

در این مدت، مأمورین اجرایی برنامه سیاناس عبارت بودند از: جان هاپفیلد، دمیتری سوالتیس، کریستوف کخ و پیترو پرونا.

فارغالتحصیلان سیاناس تعدادی کنفرانس و کارگاه آموزشی را به تنهایی یا با دیگران تأسیس کردهاند:

رایانه شناختی ترکیبی از هوشمصنوعی و الگوریتمهای ماشین است که برای پیروی از کاراهای انسان ساخته شده است. این روش به طور کلی یک رویکرد مهندسی معکوس را اتخاذ میکند. مثالی از یک رایانه شناختی با استفاده از شبکههای عصبی و یادگیری عمیق توسط ماشین واتسون کمپانی IBM تامین میشود. توسعه بعدی IBM، معماری میکرو تراشه TrueNorth است که برای نزدیکتر شدن به ساختار مغز انسان از معماری فون نیومن استفاده میشود که در رایانههای متعارف مورد استفاده قرار میگیرد.

شتابدهنده هوش مصنوعی (به انگلیسی: AI accelerator) یک کلاس از شتابدهندههای سختافزاری[۱] یا سیستم کامپیوتری[۲][۳]است که برای شتاب دهندگی به برنامههای هوش مصنوعی و یادگیری ماشین، از جمله شبکههای عصبی مصنوعی و بینایی ماشین طراحی شدهاست. برنامههای کاربردی معمولی شامل الگوریتمهایی برای رباتیک، اینترنت اشیا، و سایر وظایف مبتنی بر داده یا حسگر است.[۴] این برنامهها اغلب طرحهای چند هستهای هستند و عموماً روی محاسبات با دقت پایین ، معماریهای جدید جریان داده یا قابلیت محاسبات درون حافظه تمرکز میکنند. تا به امروز، سال ۲۰۱۸، یک تراشه مدار مجتمع هوش مصنوعی عادی حاوی میلیاردها ترانزیستور ماسفت است.[۵] چندین اصطلاح خاص تجاری برای دستگاههای این گروه به کار میرود و این فناوری، یک فناوری نوظهور بدون طراحی فراگیر است.

سیستمهای رایانهای اغلب واحد پردازش مرکزی را با شتابدهندههای ویژه برای کارهای تخصصی تکمیل میکنند که به عنوان کمک پردازنده شناخته میشوند. واحدهای سختافزاری ویژه برنامه کاربردی شامل کارتهای گرافیکی، کارتهای صدا، واحدهای پردازش گرافیکی و پردازندههای سیگنال دیجیتال هستند. همانطور که در دهه ۲۰۱۰ کاربردهای یادگیری عمیق و هوش مصنوعی افزایش یافت، واحدهای سختافزاری تخصیص یافته نیز از محصولات موجود توسعه یافتند تا به اعمال این الگوریتمها شتاب دهند

اولین طراحیها مانند ETANN 80170NX[۶] از شرکت اینتل، مدارهای آنالوگ را برای محاسبه توابع عصبی دخیل کرده بودند. نمونه دیگری از تراشههای این گروه، ANNA است که یک شتابدهنده شبکه عصبی CMOS است که توسط یان لی کان توسعه یافتهاست.[۷] بعداً نیز تمام تراشههای دیجیتال مانند Nestor/Intel Ni1000 از این تراشه الگو برداری کردند.

در اوایل سال ۱۹۹۳، پردازندههای سیگنال دیجیتال در زمینههایی مانند سرعت بخشیدن به نرمافزار تشخیص کاراکتر نوری، به عنوان شتابدهنده شبکه عصبی، مورد استفاده قرار گرفتند.[۸]

در دهه ۱۹۹۰ نیز تلاشهایی برای ایجاد سیستمهای موازی با توان عملیاتی بالا برای محیطهای کاری با هدف کاربردهای گوناگون از جمله شبیهسازی شبکههای عصبی صورت گرفت.[۹][۱۰] شتابدهندههای با مبنای FPGA نیز نخستین بار در دهه ۱۹۹۰ برای استدلال و استنباط[۱۱] و آموزش مورد بررسی قرار گرفتند. گوشیهای هوشمند نیز شروع به توسعه شتابدهندههای هوش مصنوعی کردند که اولین نمونه آن کوالکام Snapdragon 820 بود که در سال ۲۰۱۵ میلادی طراحی شد.[۱۲][۱۳]

محاسبات ناهمگن به معنی ترکیب تعدادی پردازنده تخصیص یافته در یک سیستم یا حتی یک تراشه واحد است که هر یک برای وظیفهٔ خاصی طراحی شدهاند. معماریهایی مانند ریزپردازنده سلولی[۱۴] دارای خصوصیاتی هستند که دارای اشتراکهای زیادی با شتابدهندههای هوش مصنوعی هستند، از جمله: پشتیبانی از محاسبات با دقت محدود، معماری جریان داده، و اولویت دادن به «نتیجه» بر زمان مورد نیاز. ریزپردازنده سلولی بعداً برای تعدادی از وظایف[۱۵] از جمله هوش مصنوعی به کار گرفته شدند.[۱۶]

در دهه ۲۰۰۰، واحدهای پردازش مرکزی همچنان واحدهای SIMD گستردهتری را به دست آوردند که ناشی از کاربردشان در ویدئو و بازی و پشتیبانی از انواع دادههای ساختار یافته با دقت پایین بود.[۱۷]

به دلیل افزایش کارایی واحدهای پردازش مرکزی، از آنها برای انجام وظایف الگوریتمهای هوش مصنوعی نیز استفاده میشود. پردازندههای مرکزی برای DNNهای با موازیسازی در مقیاس کوچک یا متوسط نسبت به DNNهای پراکنده و در طراحیهای با حجم کم، برتر هستند.

واحدهای پردازش گرافیکی یا GPUها، سختافزارهای تخصیص یافتهای برای اعمال تغییرات بر روی تصاویر و محاسبه خصوصیات تصاویر هستند. اساس ریاضی شبکههای عصبی و الگوریتمهای تغییر تصاویر، اعمال مشابه و مستقلاً موازی ای شامل ماتریسها هستند که باعث شدهاند پردازندههای گرافیکی بهطور روزافزون برای راه اندازی الگوریتمهای یادگیری ماشین استفاده شوند.[۱۸][۱۹][۲۰]

تا به امروز، سال ۲۰۱۶، واحدهای پردازش گرافیکی برای راه اندازی الگوریتمهای هوش مصنوعی محبوب هستند و به تکامل خود ادامه میدهند تا یادگیری عمیق را، هم برای آموزش[۲۱] و هم برای استنباط در دستگاههایی مانند ماشینهای خودران، مجهزتر کنند.[۲۲] توسعه دهندگان GPUها مانند Nvidia NVLink، در حال توسعه توانایی اتصال این سختافزارها به جریان دادههایی هستند که الگوریتمهای هوش مصنوعی از آن بهره میبرند.[۲۳] از آنجایی که واحدهای پردازش گرافیکی بهطور روزافزون در شتاب دهندگی به الگوریتمهای هوش مصنوعی به کار میروند، تولیدکنندگان واحدهای پردازش گرافیکی، سختافزارهایی تخصیص یافته برای شبکههای عصبی مصنوعی را برای سرعت بخشیدن بیشتر به این الگوریتمها در نظر گرفتهاند.[۲۴][۲۵] هستههای تانسوری برای سرعت بخشیدن به آموزش شبکههای عصبی در نظر گرفته شدهاند.[۲۵]

محیطهای کاری یادگیری عمیق همچنان در حال تکامل و رشد هستند که باعث سخت شدن طراحی سختافزارهای تخصیص یافته شدهاست. دستگاههای با قابلیت تنظیم مجدد مانند آرایههای دروازه قابل برنامهریزی میدانی (FPGA)، تکامل سختافزارها، محیطهای کاری و نرمافزارها را در کنار یکدیگر آسانتر میکنند.[۲۶][۱۱][۲۷]

شرکت مایکروسافت نیز از تراشههای FPGA برای سرعت بخشیدن استنتاج بهره بردهاست.[۲۸]

با اینکه که واحدهای پردازش گرافیکی و FPGA برای وظایف مرتبط با هوش مصنوعی عملکرد بسیار بهتری نسبت به CPUها دارند، اما همچنان ممکن است با طراحیهای خاص تر بازدهی ای تا ۱۰ برابر[۲۹][۳۰] از طریق یک مدار مجتمع مختص برنامه یا ASIC به دست آید.[نیازمند منبع]این شتابدهندهها از رویکردهایی مانند استفاده بهینه از حافظه[نیازمند منبع] یا انجام محاسبات با دقت محدودتر برای افزایش سرعت و توان عملیاتی محاسبات بهره میبرند.[۳۱] برخی از چارچوبهای ممیز شناور که با شتاب دهندگی هوش مصنوعی با دقت پایین استفاده میکنند، نیم-دقت و ممیز شناور bfloat16 هستند.[۳۲][۳۳][۳۴][۳۵][۳۶] شرکتهایی مانند گوگل، کوالکام، آمازون، اپل، فیس بوک، AMD و سامسونگ همگی در حال طراحی AI ASIC خود هستند.[۳۷][۳۸][۳۹][۴۰][۴۱][۴۲]

در ژوئن ۲۰۱۷، پژوهشگران آیبیام معماری ای را بر خلاف معماری فون نیومن معرفی کردند که متکی بر محاسبات درون حافظه ای و آرایههای حافظهٔ تغییر فاز دهنده است که برای تشخیص همبستگی زمانی اعمال میشود و قصد توسعه رویکرد محاسبات ناهمگن و سیستمهای موازی حجیم را دارند.[۴۳]

همچنین در اکتبر ۲۰۱۸، محققان IBM معماری ای متکی بر پردازش درون حافظه ای و مدلسازی شده از شبکه سیناپسی مغز انسان را برای شتاب دهندگی به شبکههای عصبی عمیق معرفی کردند.[۴۴] این سیستم بر اساس آرایههای حافظهٔ تغییر فاز دهنده است.

در سال ۲۰۱۹، محققان از مؤسسه Politecnico di Milano راه حلی از طریق یک عملیات واحد برای حل سیستمهای معادلات خطی در چند ده نانوثانیه یافتند. الگوریتم آنها متکی بر محاسبات درون حافظه ای با حافظههای مقاومتی آنالوگ بود که از طریق محاسبه ضرب ماتریس-بردار در یک گام با استفاده از قانون اهم و قانون کیرشهوف، کار میکرد که بازدهی بالایی در زمان و انرژی داشت.

پژوهشگران نشان دادند که یک مدار بازخوردی با حافظههای مقاومتی نقطه متقاطع میتواند مسائل جبری مانند سیستمهای معادلات خطی، بردارهای ویژه ماتریس و معادلات دیفرانسیل را تنها در یک گام حل کند. چنین رویکردی زمان مورد نیاز برای محاسبات را در مقایسه با الگوریتمهای دیجیتال به طرز چشمگیری کاهش میدهد.[۴۵]

در سال ۲۰۲۰ میلادی، Marega و همکارانش. آزمایشهایی را با یک ماده تونل فعال با مساحت بزرگ برای توسعه دستگاهها و مدارهای منطقی در حافظه بر اساس ترانزیستورهای اثر میدانی دروازه شناور (FGFET) معرفی کردند.[۴۶] چنین نیمه رساناهای نازک اتمی ای برای برنامههای پرکاربرد یادگیری ماشینی با انرژی کارا مورد استفاده قرار میگیرند، جایی که ساختار اصلی دستگاه برای عملیات منطقی و ذخیره دادهها استفاده میشود. این پژوهشگران مواد دو بعدی مانند دی سولفید مولیبدن که نیمه رسانا است را به کار گرفتند.[۴۶]

در سال ۲۰۲۱ میلادی، J. Feldmann و همکارانش، یک شتابدهنده سختافزاری فوتونیک مجتمع برای پردازش کانولوشنی موازی ارائه کردند.[۴۷] نویسندگان دو مزیت کلیدی فوتونیک مجتمع را نسبت به همتایان الکترونیکی آن مورد بررسی قرار دادند که آنها عبارتند از: (۱) انتقال انبوه داده موازی از طریق مالتی پلکسی تقسیم طول موج در ترکیب با شانههای فرکانسی، و (۲) سرعت تلفیق بسیار بالای دادهها.[۴۷] سیستم آنها میتواند تریلیونها عملیات انباشته چند برابری را در ثانیه پردازش کند که نشاندهنده پتانسیل فوتونیک مجتمع در برنامههای کاربردی هوش مصنوعی با دادههای حجیم است.[۴۷]

از سال ۲۰۱۶ میلادی، این زمینه هنوز در جریان است و فروشندگان، اصطلاح تجاری خود را برای معادل «شتابدهنده هوش مصنوعی» مطرح میکنند، به این امید که طرحها و APIهایشان به طرح غالب در این زمینه تبدیل شود. با وجود آنکه هیچ نقطه نظر مشترکی در مورد مرز بین این دستگاهها و همچنین شکل دقیق آنها وجود ندارد، اما چندین نمونه به جهت پر کردن این فضای جدید، با مقدار قابل توجهی از همپوشانی در قابلیتها، اختصاص یافتهاند.

در نهایت، زمانی که شتابدهندههای گرافیکی مصرفکننده روی کار آمدند، صنعت در نهایت اصطلاح به کار برده شده توسط شرکت Nvidia، یعنی "GPU"[۴۸] را به عنوان اسم جمع برای «شتابدهندههای گرافیکی» سط Direct3D، شکلهای مختلفی به خود گرفته بود.

مغز مصنوعی (یا ذهن مصنوعی) یک نرمافزار یا سختافزار همراه با تواناییهای شناختی شبیه به مغز حیوان یا انسان است.[۱][۲]

تحقیقات در زمینه «مغز مصنوعی» و شبیهسازی مغز سه نقش مهم در علم دارد:

یک مثال از مورد اول این است که محققان در دانشگاه استون بیرمنگام انگلستان[۴] با استفاده از سلولهای بیولوژیک و ایجاد خوشههای عصبی به درمانهای جدیدی نورون حرکتی آلزایمر، و بیماری پارکینسونراه یافتند.

اتاق چینی جان سرل، انتقاد هیبرت دریفوس از AI یا بحث راجر پنروه در ذهن جدید امپراتور است. این منتقدان ادعا میکنند ماشینها نمیتوانند آگاهیها و دانشهای انسان را شبیهسازی کنند. یک پاسخ به استدلالهای آنها این است که فرایندهای بیولوژیکی داخل مغز میتواند به هر درجه دقت شبیهسازی شود. این پاسخ در اوایل سال ۱۹۵۰ توسط آلن تورینگ در مقاله کلاسیک «ماشین محاسبات و اطلاعات» ساخته شدهاست.[۵]

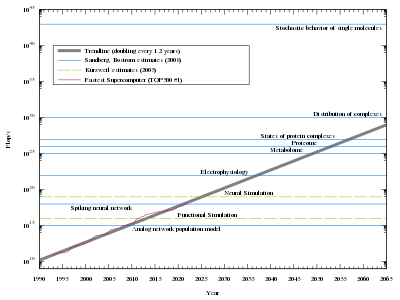

محققان مورد سوم را بهطور کلی به عنوان هوش عمومی مصنوعی میشناسند. با این حال، ری کورزوییل اصطلاح "قوی AI" را ترجیح میدهد. در کتاب خود The Singularity is Near، او با استفاده از کامپیوترهای معمولی به عنوان وسیله برای پیادهسازی مغزهای مصنوعی (هوش مصنوعی) بر روی شبیهسازی کل مغز تمرکز کردهاست و ادعا میکند که اگر به این ترتیب که قدرت کامپیوتر با روند رشد انبساطی ادامه میابد، شبیهسازی مغز انسان روی کامپیوتر تا ۲۰۲۵ میتواند انجام شود. هنری مارکرام، مدیر پروژه "مغز آبی " (که در حال تلاش برای شبیهسازی مغز است)، ادعای مشابهی در سال ۲۰۲۰ در کنفرانس TED آکسفورد در سال ۲۰۰۹ مطرح کرد.[۱]

روشهای دیگری علاوه بر رویکرد رایج تقلید مستقیم مغز انسان با استفاده از شبکههای عصبی مصنوعی بر یک موتور محاسباتی با کارایی بالا[۶] وجود دارد. اجرای یک جایگزین مصنوعی مغز میتواند بر اساس اصول هماهنگی / عدم انسجام فاز غیر خطی فناوری نانو هولوگرافی (HNeT) باشد. این قیاس با پردازشهای کوانتومی از طریق الگوریتم سیناپسی هسته ای که دارای شباهت زیادی با معادله موج مکانیکی کوانتومی دارد، ساخته شدهاست[۷] EvBrain یک نرمافزار تکاملی است که توانایی این را دارد که بلافاصله شبکههای عصبی مغزی را مثل شبکه توسعه دهد.

آی بی ام کمک هزینه ۴٬۹ میلیون دلاری از پنتاگون برای تحقیق در زمینه ایجاد رایانههای هوشمند در نوامبر ۲۰۰۸ دریافت کرد پروژه Brain Blue با کمک IBM در لوزان[۸] انجام شد. این پروژه بر این فرض استوار است که ایجاد مصنوعی نورونها در رایانه با قرار دادن سی میلیون سیناپس در موقعیت سه بعدی امکانپذیر است.

برخی از طرفداران هوش مصنوعی قوی این باورند که کامپیوترهای مربوط به مغز آبی و روح جالب ممکن است حدود سال ۲۰۱۵ از ظرفیت فکری انسان تجاوز کنند ما احتمالاً حدود سال ۲۰۵۰میتوانیم مغز انسان[۹] را دانلود کنیم

در حالی که مغز آبی میتواند ارتباطات عصبی پیچیده را در مقیاس بزرگ نشان دهد ولی ارتباط بین فعالیت مغز و رفتارهای مغز را نشان نمیدهد و این خواسته را برآورده نمیکند. در سال ۲۰۱۲، پروژه Spaun (شبکه یکپارچه معماری اشاره گر معنایی) تلاش کرد تا قسمتهای مختلف مغز انسان را از طریق نمایندگیهای گستردهای از ارتباطات عصبی مدلسازی نماید که علاوه بر نقشهبرداری، رفتارهای پیچیدهای نیز ایجاد میکند.[۱۰]

طراحی Spaun عناصر آناتومی مغز انسان را بازسازی کرد. این مدل شامل تقریباً ۲٫۵ میلیون نورون میباشد که این نورونها ویژگیهایی از جمله قوزکهای بصری و حرکتی، اتصالات GABAergic و dopaminergic، منطقه قاعده شکمی (VTA), substantia nigra دارند. این طراحی به گونه ای است که چندین تابع میتوانند با استفاده از دیدهها و حروف دست نوشته شده و کارهایی که به کمک بازوهای مکانیکی انجام میشوند به هشت کار متفاوت پاسخ بدهند. توابع Spaun شامل کپی نقاشی، شناسایی تصاویر و شمارش است.

دلایل خوبی برای باور داشتن وجود دارد که، صرف نظر از استراتژی پیادهسازی، پیشبینیهای انجام مغز مصنوعی در آینده نزدیک خوشبین هستند. [نیازمند منبع] به ویژه مغز (از جمله مغز انسان) و شناخت در حال حاضر به خوبی درک نمیشود، و مقیاس محاسبات مورد نیاز ناشناخته است. یکی دیگر از محدودیتهای نزدیک مدت این است که تمام رویکردهای فعلی برای شبیهسازی مغز نیاز به سفارش مصرف انرژی بزرگتری نسبت به مغز انسان دارد. مغز انسان حدود ۲۰ را مصرف میکند W از قدرت در حالی که ابر رایانههای فعلی ممکن است تا مقدار ۱ استفاده کنید MW یا سفارش ۱۰۰٬۰۰۰ بیشتر. [نیازمند منبع]

بعضی از منتقدان شبیهسازی مغز[۱۱] بر این باورند که به وجود آوردن مستقیم هوش بدون تقلیدکردن از طبیعت هوش سادهتر است. قضیهٔ فوق یعنی طراحی مستقیم هوش به برخی از مفسران[۱۰] کمک کرده است و منجر به تلاشهای اولیه برای ساخت ماشینهای پروازی شده است؛ اما این هواپیمای مدرن مانند پرندگان به نظر نمیآید.

مهندسی نورومورفیک (neuromorphic) یا به اختصار نورومورفیک که «محاسبات عصبی» نیز نامیده میشود، مفهومی است که در اواخر دهه ۱۹۸۰ توسط کارور مید (Carver Mead) توسعه یافته و به معنی استفاده از سیستمهای مجتمع سازی در مقیاس بسیار بزرگ (VLSI) حاوی مدارهای آنالوگ الکترونیکی، برای تقلید (شبیهسازی) معماری عصبی و بیولوژیکی موجود در سیستم عصبی است.[۱][۲]

در حال حاضر، اصطلاح نورومورفیک برای توصیف سیستمهای آنالوگ، دیجیتال، سیستمهای مختلط آنالوگ / دیجیتال و نرمافزارهایی که سیستمهای عصبی را مدلسازی میکنند، به کار میرود. اجرای محاسبات عصبی در سطح سختافزار را میتوان با ممریستورهای مبتنی بر اکسید (oxide-based memristors)، ممریستورهای اسپینترونیک (spintronic memories)، سوئیچهای آستانهای (threshold switches) و ترانزیستورها، تحقق بخشید.[۳]

جنبه اصلی مهندسی نورومورفیک درک چگونگی مورفولوژی نورونهای ویژه، مدارها، برنامهها و معماریهای همهجانبه محاسبات مدنظر را ایجاد میکند، بر نحوه ارائه اطلاعات و بر استحکام در برابر آسیبها تأثیر میگذارد، یادگیری و توسعه را ترکیب میکند، سازگاری با تغییرات محلی (انعطافپذیری)، و تغییر تکاملی را آسان میکند.

مهندسی نورومورفیک مبحثی میان رشتهای است که از زیستشناسی، فیزیک، ریاضیات، علوم کامپیوتر و مهندسی الکترونیک ایده میگیرد تا سیستمهای عصبی مصنوعی مانند سیستمهای بینایی، سیستمهای سر-چشم، پردازندههای شنوایی و روباتهای خودمختار را طراحی کند که معماری فیزیکی و اصول طراحی آن مبتنی بر اصول سیستم عصبی بیولوژیکی است.

مثالها:

در اوایل سال ۲۰۰۶، محققان در جورجیا تکنولوژی یک میدان برنامه پذیر آرایه عصبی را منتشر کردند.

مهندسی نورومورفیک به دلیل ایدههایی که از دانشمان در مورد ساختار و عملکرد مغز میگیرد، برجسته میشود. مهندسی نورومورفیک آنچه را که در مورد عملکرد مغز میدانیم به سیستمهای کامپیوتری ترجمه میکند. کار در این زمینه بیشتر بر روی تکرار ماهیت آنالوگ محاسبات زیستی و نقش نورونها در شناخت متمرکز شدهاست.

فرایند زیستی نورونها و سیناپسهای آنها بسیار پیچیدهاند، و در نتیجه شبیهسازی مصنوعی آنها بسیار مشکل است. یک ویژگی کلیدی مغزهای زیستی این است که تمام پردازشها در نورونها از سیگنالهای شیمیایی آنالوگ استفاده میکنند. این امر ساختن مغز در کامپیوتر را دشوار میسازد چرا که نسل فعلی کامپیوترها کاملاً دیجیتال هستند. با اینحال، ویژگیهای این بخشها را میتوان به توابع ریاضی که تقریباً جوهرهٔ عملیات نورون را دریافت میکنند، خلاصه کرد.

هدف محاسبات نوروموفیک این نیست که تمام و کمال از مغز و تمام عملکردهای آن تقلید کند، بلکه هدف آن این است که آنچه در مورد ساختار و عملکرد مغز میدانیم را استخراج کند تا از آن در سیستمهای کامپیوتری کاربردی استفاده شود. هیچ سیستم نوروموفیکی ادعا یا تلاش نخواهد کرد که تمام عناصر نورونها و سیناپسها را شبیهسازی کند، اما همه آنها به این ایده پایبندند که محاسبات در یک سری عناصر محاسباتی کوچک، شبیه به یک نورون، توزیع شوند.

با وجود اینکه مفهوم بینرشتهای مهندسی نورومورفیک نسبتاً جدید است، بسیاری از ملاحظات اخلاقی که درمورد ماشینهای انساننما و هوش مصنوعی وجود دارند، در مورد سیستمهای نوروموفیک هم صادقاند. با اینحال، این نکته که سیستمهای نوروموفیک برای تقلید از مغز انسان طراحی شدهاند، سوالات اخلاقی منحصر به فردی را در پیرامون استفاده از آنها ایجاد میکند.

البته بحث پیرامون این موضوع این است که سختافزار نورومورفیک همچون «شبکههای عصبی» مصنوعی مدلهای بسیار ساده شدهای از چگونگی پردازش اطلاعات و عملکرد مغز هستند و در مقایسه با مغز از نظر اندازه و تکنولوژی عملکردی، پیچیدگی بسیار پایینتر و از نظر اتصالات، ساختاری بسیار منظمتری دارند. مقایسهٔ تراشههای نورومورفیک با مغز، مقایسهای بسیار ناپخته است: همچون مقایسهٔ یک هواپیما با یک پرنده، صرفاً به دلیل این که هر دو بال و دم دارند. واقعیت این است که بازده تبدیل انرژی و محاسبهٔ سیستمهای شناختی عصبی چندین برابر بهتر از آخرین فناوریهای هوش مصنوعی است و مهندسی نوروموفیک تلاش میکند با الهامگیری از مکانیزم مغز این اختلاف را کاهش دهد.

محدودیتهای اخلاقی بسیاری ممکن است به دلیل درک عمومی بر مهندسی نورومورفیک اعمال گردد.[۴] Eurobarometer ویژهٔ ۳۸۲: نگرش عمومی نسبت به روباتها، یک نظرسنجی که توسط کمیسیون اروپا انجام شد، نشان داد که ۶۰٪ از شهروندان اتحادیه اروپا خواهان ممنوعیت استفاده از روباتها برای مراقبت از کودکان، سالمندان و معلومان هستند. همچنین، ۳۴٪ موافق ممنوعیت استفاده از روباتها در آموزش، ۲۷٪ در مراقبتهای بهداشتی و ۲۰٪ در مسائل تفریحی و فراغت بودند. این گزارش به نگرانیهای فزایندهای پیرامون روباتهایی اشاره میکند که میتوانند عملکرد انسان را تقلید یا تکرار کنند. مهندسی نورومورفیک، بنابر تعریف، طراحی شدهاست تا عملکردهای مغز انسان را تکرار کند.[۵]

به احتمال زیاد، نگرانیهای دموکراتیک پیرامون مهندسی نورومورفیک در آینده حتی عمیقتر هم خواهند شد. کمیسیون اروپا دریافت که که شهروندان اتحادیهٔ اروپا که بین ۱۵ تا ۲۴ سال دارند، در مقایسه با شهروندان بالای ۵۵ سال بیشتر امکان دارد روباتها را به شکل روباتهای انسانگونه (و نه ابزارگونه) تصور کنند. هنگامی که به این افراد تصویری از یک روبات انسانگونه نشان داده شد، ۷۵٪ شهروندان اتحادیهٔ اروپا که در سنین ۱۵ تا ۲۴ سال بودند بیان کردند که تصویر مورد نظر با تصور آنها از روباتها مطابقت دارد؛ در حالی که تنها ۵۷٪ از شهروندانی که بالای ۵۵ سال داشتند چنین پاسخی دادند؛ بنابراین، ماهیت انسانگونهٔ سیستمهای نورومورفیک ممکن است آنها را در دسته روباتهایی قرار دهد که بسیاری از شهروندان اتحادیهٔ اروپا خواهان ممنوعیت آنها در آینده باشند.[۵]

با پیشرفت فزایندهٔ سیستمهای نورومورفیک، برخی از محققان از اعطای حقوق تشخص به این سیستمها دفاع کردهاند. اگر مغز آن چیزی است که به انسانها تشخص میدهد، یک سیستم نورومورفیک باید تا چه حد از مغز انسان تقلید کند تا حقوق تشخص به آن اعطا شود؟ منتقدان توسعه فناوری در پروژهٔ مغز انسان، که هدف آن پیشرفت محاسبات الهام گرفته از مغز است، استدلال کردهاند که پیشرفت در محاسبات نورومورفیک میتواند منجر به خودآگاهی ماشینی یا تشخص شود.[۶] منتقدان استدلال میکنند که اگر قرار است با این سیستمها مانند انسانها رفتار شود، پس بسیاری از اعمالی که انسانها با استفاده از سیستمهای نورومورفیک انجام میدهند، از جمله عمل پایان دادن به سیستمهای نورومورفیک، ممکن است از نظر اخلاقی ناروا باشند چرا که این اعمال خودمختاری سیستمهای نورومورفیک را نقض میکنند.[۷]

مرکز هوش مصنوعی مشترک، یک شاخه از ارتش ایالات متحدهٔ آمریکا، مرکزی است که به تهیه و پیادهسازی نرمافزار هوش مصنوعی و سختافزار نورومورفیک برای استفادهٔ رزمی اختصاص دارد. کاربردهای خاص آن، هدست/ عینکهای هوشمند و روباتها را شامل میشود. این مرکز قصد دارد که با تکیه بر فناوری نورومورفیک، «هر جنگنده، هر تیرانداز» را در شبکهای از واحدهای مجهز به نورومورفیک متصل کند.